联邦学习的目标和最大优势是能够对用户的隐私数据进行保护,但拥有大量客户进行协作训练和暴露模型参数的去中心化方法使联邦学习容易受到各种攻击和风险。在文献[3]中,作者根据联邦学习的安全性和隐私隐患分别展开讨论。

在联邦学习构建的生态系统中,安全性风险的主要来源为以下六点:

1)通信协议:联邦学习使用随机选择的客户端实现迭代学习过程,这涉及给定网络上的大量通信。

2)客户端数据操作:中央服务器负责共享初始模型参数,聚合本地模型,并向所有客户端共享全局模型更新。应该检查用于此任务的基于云的或物理服务器,以确保服务器的公开漏洞不会被好奇的攻击者利用。

3)中央服务器:中央服务器是健壮和安全的,中央服务器负责共享初始模型参数,聚合本地模型,并向所有客户端共享全局模型更新。

4)较弱的聚合算法:聚合算法承担了本地模型的更新任务,需要智能地识别客户端更新的异常,并且提供相应的配置支持删除来自可疑客户端的更新。

5)联邦学习环境中的人员复杂度:参与联邦学习实现的架构师、开发人员和部署人员团队可能会成为安全风险的来源。由于缺乏对敏感用户数据和非敏感用户数据的理解,可能会导致安全和隐私上的风险。

6)供应链安全:联邦学习框架依赖于不同的库、第三方软件以及算法支撑,供应链层面的复杂容易引入多方风险,并对供应链安全提出了更高的挑战。

除此之外,联邦学习中,通常恶意代理利用漏洞 [6] 控制一个或多个参与者(即客户端),通过对全局模型的操控,从而影响系统安全性并违反其隐私策略。在这种情况下,攻击者可以根据机器学习的CIA模型中的机密性,可用性和完整性的前两大特性,在全局模型中发动相应攻击。

攻击者窃取训练数据中嵌入的敏感信息,通过暴露目标模型信息及其预测结果来破坏机密性,威胁参与者的隐私。主要分为以下6类:

在联邦学习中,由于每个客户端都能够接触到模型参数以及训练数据,因此一些恶意的客户端很可能会将被篡改的数据或权重发送给服务器,从而影响全局模型。

-

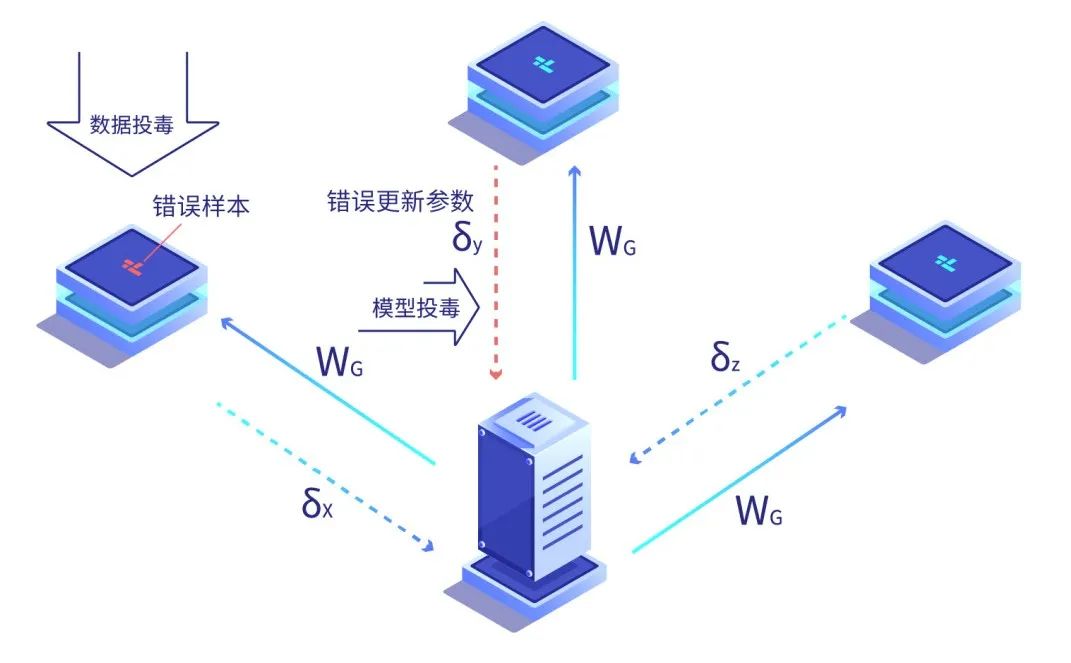

数据中毒(data poisoning):数据投毒是指攻击者通过对训练集中的样本进行污染,如添加错误的标签或有偏差的数据,降低数据的质量,从而影响最后训练出来的模型,破坏其可用性或完整性。

-

模型投毒(model poisoning):模型投毒不同于数据投毒,攻击者不直接对训练数据进行操作,而是发送错误的参数或损坏的模型来破坏全局聚合期间的学习过程[4] ,比如控制某些参与方传给服务器的更新参数,从而影响整个学习模型参数的变化方向,减慢模型的收敛速度,甚至破坏整体模型的正确性,严重影响模型的性能。

-

数据篡改(data modification):数据篡改攻击可能涉及改变训练数据集,如特征碰撞,通过合并数据集中的两个类,试图欺骗机器学习模型,达到错误分类的目地。

B. 推理攻击:更多的是对隐私的威胁,其严重性与投毒攻击非常类似。

C. 后门攻击:与后门攻击相比,投毒和推理攻击更透明。后门攻击是将恶意任务注入到现有模型中,同时保持实际任务的准确性的一种方法。

D. 恶意服务器:利用共享的计算能力在全局机器学习模型中构建恶意任务。

E. GANs:基于GAN的攻击能够发起中毒和推理攻击,对给定系统的安全性和隐私构成威胁。

通过阻止参与者获得模型的正确输出或者是干预参与者获取模型的某些特征,使参与者获取的模型不具备可靠性。可用性攻击共分为以下5类:

A . 系统中断IT停机时间:利用停机阶段从联邦学习环境中窃取信息。

B . 数据保护法相互作用:有意或无意的配置错误导致安全漏洞。

C . 搭便车攻击:利用全局机器学习模型的好处而与环境联系,而没有对培训过程做出贡献。

D . 不可用性:在训练过程中,客户的缺失或流失可能会导致全球模型的培训效率低下。这类似于搭便车攻击,但在此场景中,由于网络问题或任何其他意想不到的障碍,客户机无意中错过了参与训练过程。这种威胁的严重性是中等的,因为概率较低,而且可以选择可以异步工作的聚合算法。

E . 通信瓶颈:通信瓶颈可以显著破坏联邦学习环境,这种威胁的严重性是很高的。

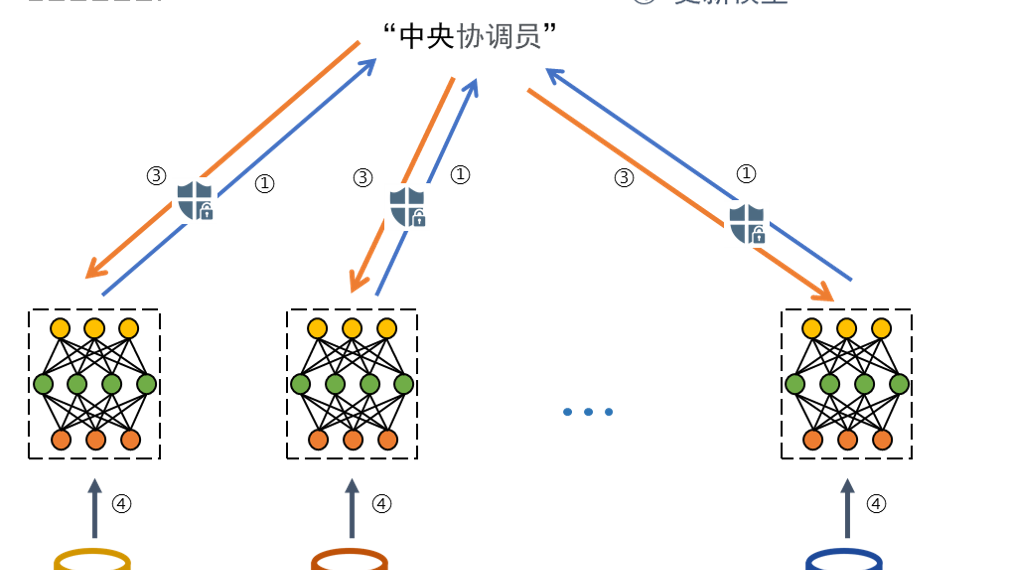

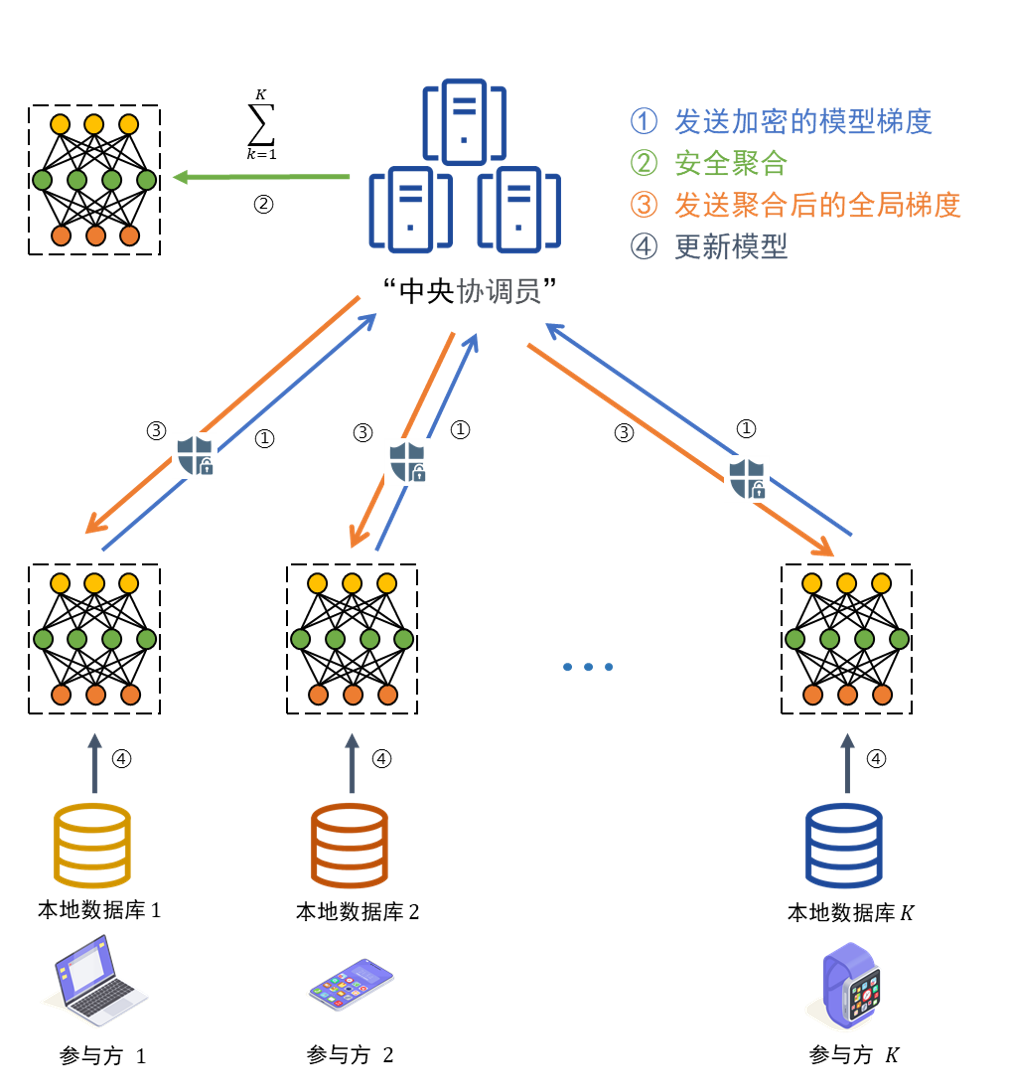

默认情况下,联邦学习通过减少网络(“中央协调员”)中的用户数据占用空间来提高隐私性,目的是通过要求参与者共享局部训练模型参数而不是他们的实际数据来保证参与者的隐私。

然而,根据最近的研究,联邦学习仍然存在一些隐私威胁,因为对手可以根据每个参与者上传的参数部分揭示原始训练数据集中的每个参与者的训练数据。

联邦学习中的这些关键威胁可以概括为不同类型的推理攻击:

是一种推断训练数据细节的方法,这种攻击通过检查训练数据集上是否存在特定的数据来获取信息。

数据泄露的危害以及恶意的客户端通过全局模型来重构其他客户端的训练数据。

Hitaj等 [5] 发现,联邦学习框架对于系统内部参与者发起的主动攻击是极为脆弱的。他们首次提出了一种由系统内恶意用户发起的基于GAN的重建攻击。在训练阶段,攻击者可以假扮成良性用户,训练一个GAN用于模拟其他用户训练数据产生的原型样本。通过不断注入伪造的训练样本,攻击能够逐步影响整个学习过程并且诱使受害者释放更多与攻击者目标类有关的敏感信息。

后期我们将重点介绍在联邦学习中,结合同态加密、安全多方计算和差分隐私等隐私保护技术,更好的推动联邦学习应用安全落地。

上海同态科技信息有限公司,是完全基于密码技术实现隐私计算的团队,相关产品和解决方案完全依托同态加密技术路径发展而来。公司主要从事网络安全技术应用、云计算安全、数据隐私保护,提供互联网、物联网、云计算等领域所需的相关信息安全与密码产品。

,并且了解优化器的设定。对于拥有固定学习率ŋ的分布式梯度下降算法的第t轮更新全局模型参数时,第k个参与方基于本地数据集计算

,并且了解优化器的设定。对于拥有固定学习率ŋ的分布式梯度下降算法的第t轮更新全局模型参数时,第k个参与方基于本地数据集计算

指第k个参与方的数据量,是第k个参与方的本地目标函数。上述方法称为模型平均算法[2]。

指第k个参与方的数据量,是第k个参与方的本地目标函数。上述方法称为模型平均算法[2]。