报告简介:金融服务业数字化的发展高度依赖优质的信息质量与 分析技术,从而为客户提供高效安全的服务及运营管理。人工智能(AI)的发展改变了信息处理和数据分析方式,并为金融机构实现了诸如业务流程简化、降低成本、提高效率和增强客户参与度等多重益处,金融机构很早便开始应用人工智能服务。根据某技术服务商在2022年对全球金融机构进行的调研显示,有78%的受访者表示他们正在使用至少一种形式的人工智能,包括机器学习、深度学习和高性能计算(HPC)。

在本文中,我们将AI定义为计算机科学的一个分支,旨在探索并模拟人类认知功能,例如,如何学习和解决问题。我们将主要从监管角度讨论人工智能,包括亚太地区监管机构制定的AI相关原则及其对该地区金融机构所产生的影响,以及金融机构为应对监管要求和消除客户的担忧所需采取的行动。

01、透明性和问责制

监管机构共同关注的重点在于人工智能“黑匣子”的性质,以及如何让金融机构对基于AI输出结果所做出的决策负责。如上所述,AI应用程序并非基于预先确定的规则而构建的,而是可以理解为对规则、变量和数据输入进行解读。本报告所定义的AI应用依赖于机器学习中的训练数据和实时数据输入,因此较难向内外部用户解释其所输出的结果。为解决该问题,透明性和可解释性原则要求使用AI应用程序的金融机构要确保其人工智能 模型的透明性和信息披露程度要达到能使客户理解的水平。例如,当AI模型根据投保人的生活方式建议保险公司对其增加保费时,保险公司应当能够向投保人解释为何这种生活方式会导致其保费增加。各司法辖区监管机构对透明性和可解释性原则的具体监管预期不同,香港金融管理局要求金融机构建立相关机制,让客户可以对AI应用所做出的决策进行审查。针对FEAT原则,新加坡金融管理局对披露AI应用技术细节所需的成本和 效益进行了研究,并提出应按受影响方的要求向其明确解释人工智能决策过程,但不用披露AI应用的专有技术信息。

澳大利亚人工智能道德框架在可解释性方面增加一个维度,即AI应用的可争议性。可争议性是指人工智能应用机构为受影响方提供一条可以对AI输出结果提起异议的通道。这一要求可以推动客户与AI流程进行交互并对某些影响决策结果的因素提出质疑。可争议性要素与可解释性原则密切相关。例如,当受影响方对AI决策提出质疑时,应向其提供明确的解释,以确保决策所涉各方均了解决策制定过程。

透明性原则对客户受到公平对待和机构取得满意的业务成果均具有重要意义。经合组织在其2019年发布的《人工智能指导原则》中指出,应向所有与AI系统进行交互的利益相关者进行适当披露。换言之,利益相关者需要明确了解AI输出结果的过程以做出明智的决策,包括在前端使用AI应用为客户提供产品的人员、基于AI模型判断承保风险的人员、使用AI应用预测违约率和计算准备金的风险管理团队以及确保遵守法律法规的内控团队。

02、公平性和稳健性

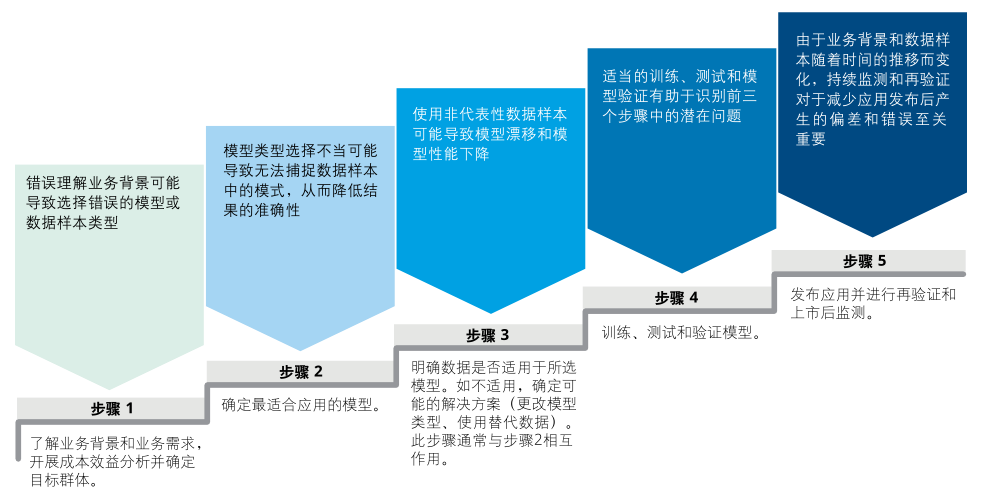

监管机构的另一关注重点在于保护客户免受潜在歧视和其他不公平待遇。由于向客户所收集的作为训练数据和模型输入的个人数据体量较大,因此收集和使用这些数据的方式可能会对为客户提供的产品和服务产生重大影响。AI生成的结果将用于帮助客户做出决策,而公平性的核心是确保结果的准确性和公正性。因此,稳健性原则与公平性原则密切相关。公平性和稳健性原则通常包括以下要求:

第一、金融服务业的AI应用应具有包容性,不应歧视某些个人或群体。任何涉及个人属性的使用均应具有合理性;

第二、基于AI应用提出的建议应符合客户的实际情况;

第三、AI应用使用的模型应具有稳健性、准确性和公正性。

表1 如何在AI应用开发过程中确保结果的公正性和准确性

03、隐私和数据安全

隐私和数据安全原则并非仅针对人工智能在金融行业的应用,其适用于所有收集、传输和存储个人数据的公司。该项原则是人工智能应用的基本构建模块。虽然在许多亚太司法辖区人工智能相关法规仍处于萌芽阶段,但近年来,数据隐私法律法规已得到较好的发展和推广。贯彻隐私和数据安全原则的关键是确保在人工智能应用的整个生命周期内遵守数据保护法律。

关于数据隐私、数据保护和网络安全的法律法规。运营韧性方面的最新监管要求也将对金融机构的监管审查扩大到了外包承包商、第三方供应商及其分包商。遵守这些法规对采用AI应用的金融机构至关重要。

值得注意的是,在某些司法辖区,向客户索取的数据必须具有既定用途,金融机构不得在未明确未来用途的情况下索取和存储数据并用于AI建模。因此,在不存在明确用例的情况下向系统中添加数据字段可能具有一定监管风险。就此而言,需要制定以相关法规为依据的长期数据战略。

表2 如何在AI应用开发过程中确保结果的公正性和准确性

*关注公众号回复“人工智能”获取报告

本篇文章来源于微信公众号: 数字金融网